0 引言

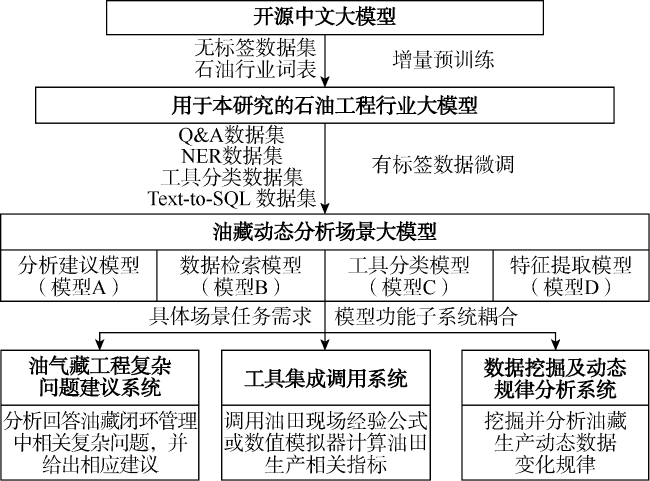

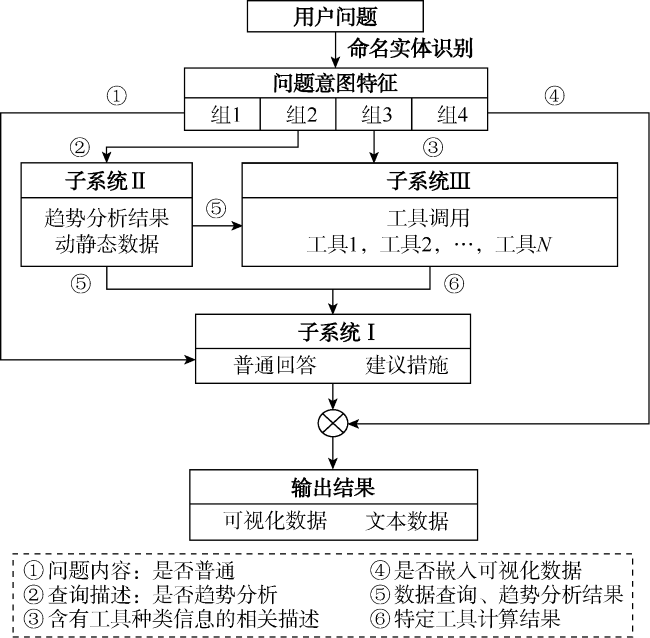

1 油藏动态分析场景大模型构建思路

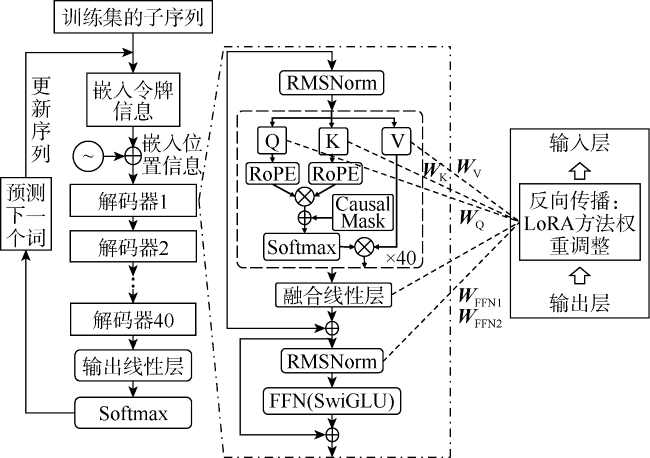

1.1 增量预训练

1.2 子系统指令微调

1.3 功能子系统耦合

2 面向油藏动态分析场景功能的模型微调实现与测试

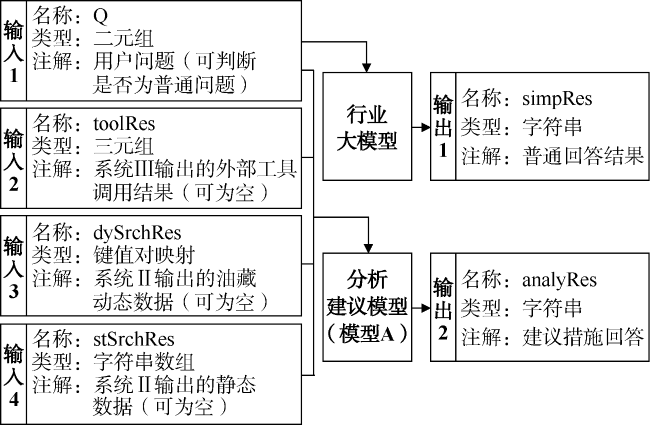

2.1 分析建议模型的微调与测试

表1 分析建议模型的QA性能测试 |

| 评判 专家 | 评判样本 总数 | 相关维度 | 准确维度 | 完整维度 | 流畅维度 | ||||

|---|---|---|---|---|---|---|---|---|---|

| 准确样本数 | 准确率/% | 准确样本数 | 准确率/% | 准确样本数 | 准确率/% | 准确样本数 | 准确率/% | ||

| 专家1 | 330 | 307 | 93.0 | 295 | 89.4 | 326 | 99.0 | 330 | 100.0 |

| 专家2 | 330 | 315 | 95.5 | 297 | 90.0 | 324 | 98.0 | 328 | 99.4 |

| 专家3 | 330 | 298 | 90.3 | 282 | 85.5 | 310 | 93.9 | 326 | 98.8 |

| 综合 | 330 | 92.9 | 88.3 | 96.7 | 99.4 | ||||

2.2 特征提取模型的微调与测试

表2 命名实体识别模型的NER性能测试 |

| 命名实体 | 定义 | 总样本数 | 实体识别 | 数字变量实体识别 | 语意识别 | |||

|---|---|---|---|---|---|---|---|---|

| 正确样本数 | 可识别率/% | 正确样本数 | 准确率/% | 正确样本数 | 准确率/% | |||

| Well_id | 井号 | 1 300 | 1 275 | 98.1 | 1 247 | 96.5 | ||

| Well_layer | 层号 | 1 300 | 1 235 | 95.0 | 1 222 | 94.0 | ||

| Data_from | 起始时间 | 1 300 | 1 287 | 99.0 | 1 274 | 98.0 | ||

| Data_to | 终止时间 | 1 300 | 1 287 | 99.0 | 1 274 | 98.0 | ||

| Period | 阶段(如每年) | 1 300 | 1 261 | 97.0 | 1 274 | 98.0 | ||

| Target | 主要问题(如产油) | 1 300 | 1 209 | 93.0 | 1 189 | 91.5 | ||

| Wanted_type | 展示类型(如曲线图) | 1 300 | 1 235 | 95.0 | 1 168 | 89.8 | ||

2.3 数据检索模型的微调与测试

表3 数据检索模型的Text-to-SQL性能测试 |

| 模型准确率标准 | 微调前匹配情况 | 微调后匹配情况 | 微调后执行情况 | ||||

|---|---|---|---|---|---|---|---|

| 分级 | 总样 本数 | 准确 样本数 | 准确率/ % | 准确 样本数 | 准确率/ % | 准确 样本数 | 准确率/ % |

| 简单 | 700 | 485 | 69.3 | 700 | 100.0 | 700 | 100.0 |

| 中等 | 500 | 337 | 67.4 | 498 | 99.6 | 462 | 92.4 |

| 复杂 | 80 | 46 | 57.5 | 70 | 87.5 | 53 | 66.3 |

| 极难 | 20 | 5 | 25.0 | 11 | 55.0 | 8 | 40.0 |

| 总体 准确率 | 67.3 | 98.3 | 95.2 | ||||

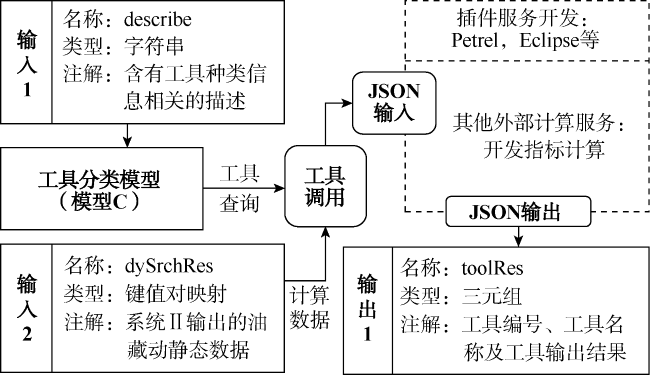

2.4 工具分类模型的微调与测试

表4 3种不同的工具识别方法及其准确性评估 |

| 识别工具 | 准确样本数 | 准确率/% |

|---|---|---|

| NER直接识别工具 | 467 | 35.9 |

| 分类任务直接区分工具 | 423 | 32.5 |

| NER提取主旨信息(Target)+ 分类任务区分工具 | 1 161 | 89.3 |