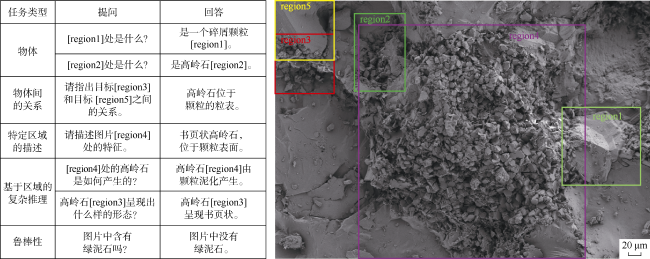

油气勘探方面,中国石油勘探开发研究院FalconCore团队以SAM为基础模型,在薄片、扫描电镜、CT等标注过的岩石图像上进行微调,研发岩石图像实例分割大模型,支撑了FalconCore的薄片智能鉴定、扫描电镜孔缝分析等工作

[77⇓-79]。该团队还在LLaMA的基础上微调构建电成像测井图像智能修复模型

[80],在空白条带占比大的情况下,修复效果明显优于Filtsim等传统修复算法。张东晓团队提出的RockGPT

[81]利用条件生成模型从单个二维切片重建三维数字岩石,进而获得三维数字化多孔结构,有利于研究油藏或地下含水层中的孔隙尺度流动。Sheng等

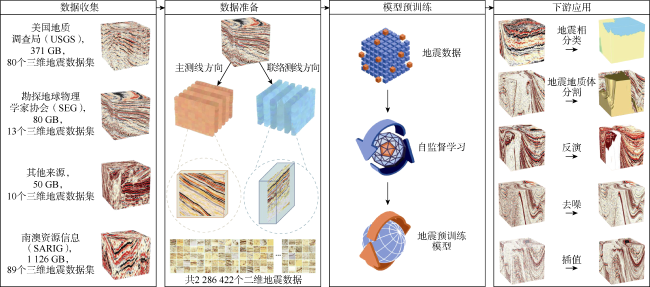

[82]收集了大量地震数据体,通过自监督学习来预训练基于Transformer的地震基础模型(Seismic Foundation Model,SFM),训练得到的基础模型可以应用于下游地震相分类、地震地质体分割、反演等任务。在油气领域中,通过SFM可以更高效、准确地解析大量地震数据,提取关键特征,进而可以提高油藏勘测准确率和优化钻井钻探决策。Zhang等

[83]针对岩性识别问题,对400 m连续取心图像做预处理,构建了十万/百万级别训练样本,从而识别24种岩性,还提出了基于Multiscale Vision Transformer (MVIT-V2)等大模型架构的厘米级别识别方案。传统的语义分割模型严重依赖于大规模的标注数据集,尤其是对于复杂的CT和SEM岩石图像。SAM则具有一定的零样本分割能力,同时也满足了储层建模中对高精度分割的需求,这对于只有有限数据和具有复杂图像特征的数字岩石物理学研究非常重要

[84]。RockSAM

[85]利用微调的SAM解决了零样本数字岩石图像分割问题。具体而言,SAM模型在应用于数字岩石图像时,由于其特征对比度较低导致分割结果出现一定的局限性,为了解决这一问题,RockSAM对SAM进行了微调,产生了RockSAM的变体,该变体提高了数字岩石图像的分割精度,同时不牺牲其零样本学习能力。这种调整确保了RockSAM的有效性,为数字岩石图像分析提供了一个高价值的工具。除此之外,RockSAM在生成高质量分割掩模方面也表现出显著的效率,克服了对复杂标注数据的需求,用最少的人工干预和数据进行学习和适应,不仅提高了数字岩石图像分析的准确性,而且预示着基础模型在石油和天然气行业的成功应用。